I sottotitoli sono una tecnica efficace per migliorare l'accessibilità, il coinvolgimento e la memorizzazione delle informazioni durante presentazioni ed eventi dal vivo. Questo, insieme al cambiamento delle abitudini di fruizione video nell'ambito dello streaming, ha recentemente accelerato l'adozione di sottotitoli basati sull'intelligenza artificiale in eventi dal vivo e meeting aziendali.

Ma quando si tratta di scegliere un fornitore per il proprio meeting o evento, la domanda più frequente è: quanto sono precisi i sottotitoli automatici in tempo reale?

La risposta rapida è che, in condizioni ideali, i sottotitoli automatici nelle lingue parlate possono raggiungere una precisione fino al 98%, come valutato dal Word Error Rate (WER).

E sì, la risposta è lunga e leggermente più complessa. In questo articolo, vogliamo offrirvi una panoramica su come viene misurata l'accuratezza, quali fattori la influenzano e come portarla a nuovi livelli.

In questo articolo

- Come funziona il sottotitolaggio automatico

- Cosa si intende per buona qualità dei sottotitoli?

- Quali fattori influenzano la precisione?

- Misurazione dell'accuratezza dei sottotitoli automatici

- Comprensione del tasso di errore delle parole (WER)

- Ottenere sottotitoli incredibilmente precisi per i tuoi eventi in diretta

Prima di addentrarci nei numeri, facciamo un passo indietro e vediamo come funzionano i sottotitoli automatici.

Come funziona il sottotitolaggio automatico

Sottotitoli automatici

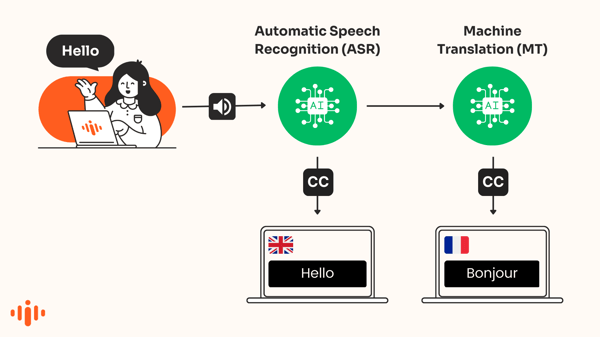

I sottotitoli automatici convertono il parlato in testo che viene visualizzato sullo schermo in tempo reale nella stessa lingua del parlato. L'ASR (Automated Speech Recognition) è una sorta di intelligenza artificiale utilizzata per produrre queste trascrizioni di frasi pronunciate.

La tecnologia, spesso nota come "speech-to-text", viene utilizzata per riconoscere automaticamente le parole nell'audio e trascrivere la voce in testo.

Didascalie tradotte dall'intelligenza artificiale

I motori di traduzione basati sull'intelligenza artificiale traducono automaticamente i sottotitoli che appaiono in una lingua diversa. Questo processo è noto anche come sottotitoli tradotti automaticamente o didascalie tradotte automaticamente.

Articolo consigliato

Perché dovresti prendere in considerazione l'aggiunta di sottotitoli in tempo reale al tuo prossimo evento

In questo articolo parleremo dei sottotitoli automatici. Per saperne di più sull'accuratezza dei sottotitoli tradotti dall'intelligenza artificiale, consulta questo articolo .

Cosa si intende per buona qualità dei sottotitoli?

Nel 2014 la Federal Communications Commission (FCC) ha stabilito le caratteristiche essenziali per determinare se i sottotitoli sono "eccellenti":

- Precisione: le didascalie devono corrispondere il più possibile alle parole pronunciate

- Completezza : i sottotitoli vanno dall'inizio alla fine della trasmissione, nella misura più completa possibile.

- Posizionamento : le didascalie non bloccano i contenuti visivi importanti e sono facili da leggere.

- Sincronizzazione : i sottotitoli si allineano alla traccia audio e vengono visualizzati a una velocità leggibile.

Immagine: sottotitoli in tempo reale tradotti dall'intelligenza artificiale durante un webinar

Quali fattori influenzano la precisione?

Il motore di intelligenza artificiale selezionato

Non tutti i motori di sintesi vocale producono risultati identici. Alcuni sono migliori in generale, mentre altri lo sono in determinate lingue. E anche utilizzando lo stesso motore, i risultati possono variare notevolmente a seconda degli accenti, dei livelli di rumore, degli argomenti trattati e così via.

Ecco perché, in Interprefy, confrontiamo costantemente i migliori motori di traduzione per determinare quale generi i risultati più accurati. Di conseguenza, Interprefy può fornire agli utenti la soluzione migliore per una lingua specifica, tenendo conto di aspetti come latenza e costi. In condizioni ideali, abbiamo riscontrato un'accuratezza costante fino al 98% per diverse lingue.

La qualità dell'input audio

Per produrre un output di qualità, la tecnologia di riconoscimento vocale automatizzato richiede un input di qualità. È semplice: maggiore è la qualità e la chiarezza dell'audio e della voce, migliori saranno i risultati.

- Qualità audio - Proprio come nell'interpretazione di conferenza , un hardware di input audio scadente, come i microfoni integrati nei computer, può avere un impatto negativo.

- Discorso e pronuncia chiari: i relatori che parlano ad alta voce, con un ritmo adeguato e in modo chiaro, solitamente riceveranno sottotitoli più precisi .

- Rumore di sottofondo: forti rimbombi, cani che abbaiano o fogli che scorrono vengono rilevati dal microfono e possono deteriorare notevolmente la qualità dell'input audio.

- Accenti: i parlanti con accenti insoliti o forti, così come i parlanti non madrelingua, rappresentano un problema per molti sistemi di riconoscimento vocale.

- Sovrapposizione di parole: se due persone parlano una sopra l'altra, il sistema avrà molte difficoltà a individuare correttamente chi parla.

Articolo consigliato

Quanto sono precisi i sottotitoli in Zoom, Teams e Interprefy?

Come misurare l'accuratezza dei sottotitoli automatici

Il parametro più comune per misurare l'accuratezza dell'ASR è il Word Error Rate (WER), che confronta la trascrizione effettiva del parlante con il risultato dell'output dell'ASR.

Ad esempio, se 4 parole su 100 sono sbagliate, la precisione sarà del 96%.

Comprensione del tasso di errore delle parole (WER)

Il WER determina la distanza più breve tra un testo di trascrizione generato da un sistema di riconoscimento vocale e una trascrizione di riferimento prodotta da un essere umano (la verità di base).

Il WER allinea le sequenze di parole identificate correttamente a livello di parola prima di calcolare il numero totale di correzioni (sostituzioni, cancellazioni e inserimenti) necessarie per allineare completamente i testi di riferimento e di trascrizione. Il WER viene quindi calcolato come il rapporto tra il numero di correzioni necessarie e il numero totale di parole nel testo di riferimento. Un WER più basso indica generalmente un sistema di riconoscimento vocale più accurato.

Esempio di tasso di errore di parola: precisione del 91,7%

Prendiamo ad esempio un tasso di errore di parola dell'8,3%, ovvero un'accuratezza del 91,7%, e confrontiamo le differenze tra la trascrizione originale del discorso e le didascalie create da ASR:

| Trascrizione originale: | Output dei sottotitoli ASR: |

| Ad esempio, preferisco che si faccia un uso molto limitato degli elementi essenziali forniti. Vorrei approfondire un punto specifico. Temo che chiedere ai parlamenti dei singoli Stati di ratificare la convenzione solo dopo che sarà stato chiarito il ruolo della Corte di giustizia europea potrebbe avere effetti molto negativi. | Ad esempio, anch'io vorrei eccezioni venissero utilizzate solo in misura molto limitata. Vorrei approfondire un punto specifico. Temo che la richiesta ai parlamenti dei singoli Stati di ratificare la convenzione solo dopo che sarà stato chiarito il ruolo della Corte di giustizia europea potrebbe avere effetti molto negativi. |

In questo esempio, le didascalie hanno omesso una parola e ne hanno sostituite quattro:

- Misure: {'corrispondenze': 55, 'eliminazioni': 1, 'inserimenti': 0, 'sostituzioni': 4}

- Sostituzioni: [('too', 'do'), ('use', 'used'), ('exemptions', 'essentials'), ('the', 'i')]

- Eliminazioni: ['vorrebbe']

Il calcolo del tasso di errore delle parole è quindi:

WER = (eliminazioni + sostituzioni + inserimenti) / (eliminazioni + sostituzioni + corrispondenze) = (1 + 4 + 0) / (1 + 4 + 55) = 0,083

WER trascura la natura degli errori

Ora, nell'esempio sopra, non tutti gli errori hanno lo stesso impatto.

La misurazione del WER può essere ingannevole perché non ci informa sulla rilevanza/importanza di un determinato errore. Errori semplici, come l'ortografia alternativa della stessa parola (mobile/mobile), non vengono spesso considerati errori dal lettore, mentre una sostituzione (esenzioni/essenziali) potrebbe avere un impatto maggiore.

I valori WER, in particolare per i sistemi di riconoscimento vocale ad alta precisione, possono essere fuorvianti e non sempre corrispondono alla percezione umana di correttezza. Per gli esseri umani, le differenze nei livelli di accuratezza tra il 90 e il 99% sono spesso difficili da distinguere.

Tasso di errore percepito nelle parole

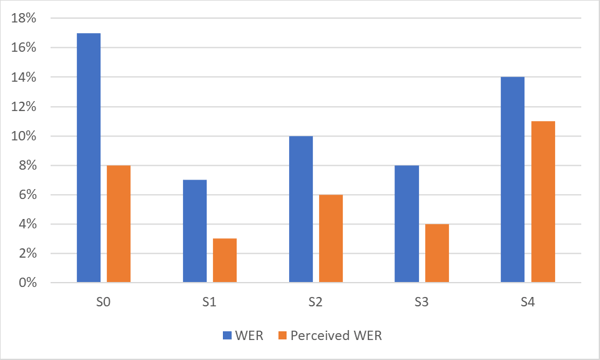

Interprefy ha sviluppato una metrica di errore ASR proprietaria e specifica per ogni lingua, chiamata WER Percepito. Questa metrica considera solo gli errori che influiscono sulla comprensione umana del parlato e non tutti gli errori. Gli errori percepiti sono solitamente inferiori al WER, a volte anche del 50%. Un WER percepito del 5-8% è solitamente difficilmente percepibile dall'utente.

Il grafico seguente mostra la differenza tra WER e WER percepito per un sistema ASR ad alta accuratezza. Si noti la differenza di prestazioni per diversi set di dati (S0-S4) dello stesso linguaggio.

Come mostrato nel grafico, il WER percepito dagli esseri umani è spesso sostanzialmente migliore del WER statistico.

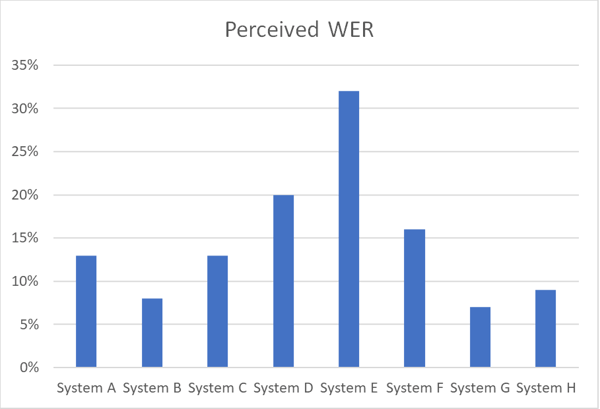

Il grafico seguente illustra le differenze di accuratezza tra vari sistemi ASR che lavorano sullo stesso set di dati vocali in una determinata lingua utilizzando Perceived WER.

Ottenere sottotitoli incredibilmente precisi per i tuoi eventi in diretta

Abbiamo riscontrato un'accuratezza del 97% per i nostri sottotitoli automatici grazie alla combinazione della nostra soluzione tecnica unica e dell'attenzione che dedichiamo ai nostri clienti. Alexander Davydov, Responsabile della fornitura di intelligenza artificiale presso Interprefy

Se vuoi che i sottotitoli automatici siano estremamente accurati durante un evento, ecco tre cose fondamentali che dovresti considerare:

Utilizza una soluzione best-in-class

Invece di scegliere un motore preconfezionato che copra tutte le lingue, scegli un fornitore che utilizzi il miglior motore disponibile per ogni lingua del tuo evento.

Vuoi scoprire cosa può offrirti il miglior motore? Leggi il nostro articolo: Il futuro dei sottotitoli in tempo reale: come l'intelligenza artificiale di Interprefy potenzia l'accessibilità.

Ottimizzare il motore

Scegli un fornitore che possa integrare l'intelligenza artificiale con un dizionario personalizzato per garantire che i nomi dei marchi, i nomi strani e gli acronimi vengano acquisiti in modo appropriato.

Garantire un input audio di alta qualità

Se l'ingresso audio è scadente, il sistema ASR non sarà in grado di raggiungere la qualità di uscita. Assicuratevi che il parlato possa essere catturato in modo forte e chiaro.

Vuoi effettuare una valutazione della qualità dei sottotitoli tramite intelligenza artificiale?

Altri link per il download

Altri link per il download